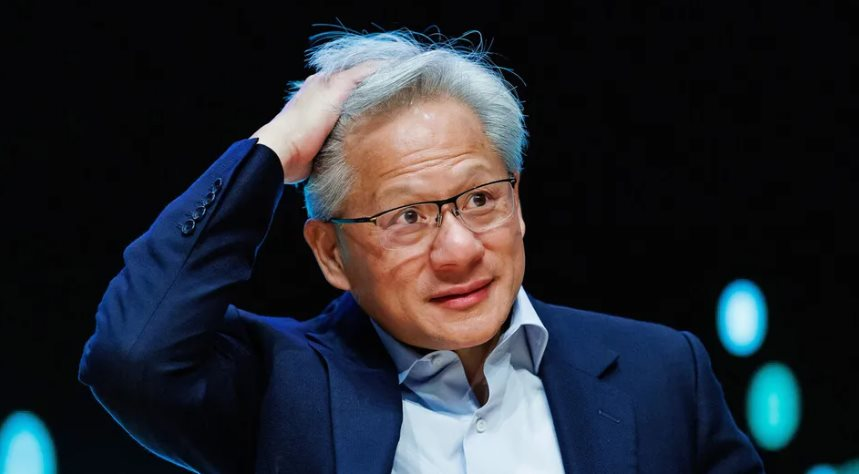

Cuối tháng 10, Jensen Huang, đồng sáng lập kiêm CEO Nvidia đã bước lên sân khấu tại hội nghị thường niên GTC và đưa ra một tuyên bố quen thuộc nhưng “rúng động”: Nvidia đang đứng “ở tâm chấn của cuộc cách mạng công nghiệp lớn nhất trong lịch sử loài người”, vượt cả kỷ nguyên đầu máy hơi nước và điện.

Ông công bố loạt bắt tay choáng ngợp: Nvidia dự định cùng Uber chế tạo 100.000 xe tự hành; liên minh với Palantir để cung cấp phần mềm và chip giúp tăng tốc hành trình hàng hóa từ kho đến cửa nhà và đưa ra bản thiết kế chỉ cho các “hyperscaler” cách dựng “nhà máy AI”, các trung tâm dữ liệu quy mô gigawatt vận hành ở công suất tối ưu nhờ… hệ thống của Nvidia.

Bài phát biểu của Huang đã “bơm” sự phấn khích cho giới hâm mộ Nvidia đến mức vốn hóa công ty bật tăng 5% chỉ trong một ngày, tương đương 250 tỷ USD, lớn hơn 60% tổng giá trị của Boeing. Đà tăng này đưa Nvidia trở thành công ty đầu tiên chạm mốc 5.000 tỷ USD vốn hóa. Theo MarketBeat, 46/47 nhà phân tích khuyến nghị “mua mạnh” hoặc “mua” cổ phiếu Nvidia.

Tuy vậy, một nhóm nhỏ các nhà đầu tư lớn tuổi tỏ ra hoài nghi, hoặc không thấy mọi thứ “hồng” như Huang và nhà đầu tư tưởng tượng. Mối lo của họ xoay quanh cách Nvidia tìm cách giữ ngôi vương: Dựng nên một siêu cấu trúc phức tạp, chưa từng có về quy mô, gồm các khoản đầu tư và tài trợ cho chính khách hàng của mình để thúc đẩy và duy trì nhu cầu đối với sản phẩm Nvidia. Chiến lược này xoay quanh OpenAI và “đám mây mới” CoreWeave, vừa là kỹ nghệ tài chính, vừa là kỹ nghệ tính toán tăng tốc.

Jay Goldberg (Seaport Global Securities), người duy nhất trên Phố Wall đang khuyến nghị “bán” Nvidia nói thẳng: “Nvidia đang mua cầu”. Lisa Shalett, CIO của Morgan Stanley Wealth Management cho rằng vấn đề cốt lõi là nợ, không phải nợ của Nvidia, mà là của khách hàng Nvidia. “Nvidia đang chống lưng cho khách hàng để chính mình tiếp tục tăng trưởng”, bà nói. “Ngày càng phức tạp vì những bên họ rót vốn lại yếu, và Nvidia đang cho phép họ vay thêm”.

Nvidia từ chối bình luận. Nhưng để hiểu biểu tượng quyền lực của nền kinh tế Mỹ mới đi đến đây thế nào, cần nắm ba điểm: Tương quan lực lượng giữa các hyperscaler lớn (Amazon, Microsoft, Alphabet, Meta) đang dựng các trung tâm dữ liệu AI khổng lồ, “neocloud” đang trỗi dậy thách thức họ; và nỗi lo sâu kín nhất của Jensen Huang.

THỐNG TRỊ AI

Trong phần lớn 32 năm tồn tại, Nvidia tập trung làm chip đồ họa 3D cho game PC và từng lao đao, có lúc cạn tiền. Năm 1999, hãng ra mắt GPU siêu mạnh có thể xử lý các phép tính phức tạp để dựng ảnh nhanh vượt trội. Chuỗi đột phá thập niên 2000 mở đường cho “học sâu”, lần lượt bứt phá ở dịch máy, rồi nhận diện hình ảnh. Khoảng 2012, Nvidia “tất tay” vào GPU và phần cứng tối ưu cho AI, kèm nền tảng phần mềm CUDA giúp lập trình viên khai thác tối đa sức mạnh chip.

Khi OpenAI tung ChatGPT cuối 2022, làn sóng AI bùng nổ, và Nvidia đã đặt mình đúng chỗ để cưỡi sóng. GPU của hãng vừa mạnh, vừa hiệu quả theo đơn vị điện năng khi chạy lượng tính toán khổng lồ của AI. Năm tài chính 2023, lợi nhuận của Nvidia còn “khiêm tốn” 4,4 tỷ USD. Bốn quý gần đây, con số đã vọt lên 86,6 tỷ USD, biến Nvidia thành “cỗ máy kiếm tiền” lớn thứ hai giới công nghệ, chỉ sau Alphabet (124,3 tỷ), trên cả Apple (112 tỷ) và Microsoft (104,9 tỷ), vượt Amazon lẫn Meta.

Khác với nhiều “ngôi sao” từng bị thổi giá rồi sụp đổ (như thời bong bóng viễn thông cuối 1990 đầu 2000), không ai phủ nhận Nvidia đang in tiền. Nhưng rõ ràng gã khổng lồ này phụ thuộc vào một vài khách hàng siêu lớn. Quý II năm nay, 52% doanh thu Nvidia đến từ ba khách không nêu tên, giới phân tích xác định là Microsoft, Amazon và Alphabet. Meta và Elon Musk (qua xAI và Tesla) cũng mua lớn.

Đa dạng hóa quốc tế không dễ, nhất là khi Trung Quốc cấm nhập các chip hạ cấp của Nvidia để đáp trả chiến tranh thương mại, còn chính quyền ông Trump siết xuất khẩu dòng GPU “đỉnh”. Năm ngoái, nền kinh tế lớn thứ hai thế giới đóng góp hơn 1/8 doanh thu qua khách như Baidu, Alibaba. Tỷ lệ này đã giảm và có thể tiếp tục co lại, khiến Nvidia càng dựa vào “bộ tứ” Big Tech.

Huang hiểu rủi ro của việc dựa quá nặng vào vài người mua siêu quyền lực. Một nguồn tin am hiểu hạ tầng AI cho biết động cơ chính của Nvidia là tránh số phận chung của nhà cung ứng phần cứng: Bị “hàng hóa hóa”.

“Phần cứng là mảng kinh doanh có biên lợi nhuận mỏng, và Nvidia biết lợi thế công nghệ ở phần cứng chỉ kéo dài được một thời gian”, nguồn tin nói. “Họ sợ bị biến thành hàng hóa như nhà sản xuất CPU, quyền mặc cả suy giảm, biên lợi nhuận khổng lồ sụp đổ”. Hiện Nvidia là ngoại lệ kỳ diệu: Năm tài chính 2025, biên gộp gần 80%, bỏ xa AMD (dưới 50%) và Intel (30%).

Đến nay, Nvidia vẫn “cầm roi”. “GPU của họ vượt trội tới mức gần như độc quyền”, Goldberg nhận xét. Vì vậy, những công ty như Amazon hay Meta dù rất lớn vẫn chưa áp được “đòn” thường thấy của người mua khổng lồ lên nhà cung ứng. Các hyperscaler đang cố lấy lại thế thượng phong.

Nhưng họ sẽ làm như vậy bằng cách nào? Họ không muốn chỉ là khách của Nvidia, mục tiêu dài hạn là cạnh tranh bằng chip tự thiết kế. Microsoft có Maia, Amazon có Trainium và Inferentia. Google đã chuyển phần lớn sang silicon “cây nhà lá vườn” TPU.

Áp lực này sẽ kéo giá xuống. CEO Amazon Andy Jassy viết trong báo cáo 2024: “Phần lớn AI đến nay xây trên một nhà cung cấp chip. Rất đắt. Không cần và sẽ không còn đắt như vậy”. Lãnh đạo Microsoft cũng nhấn mạnh muốn có silicon riêng. Gil Luria (D.A. Davidson) tóm gọn: “Nvidia muốn đa dạng hóa khỏi Big Four, còn Big Four muốn đa dạng hóa khỏi Nvidia”.

Song các tay chơi khác cũng đang “đổ bộ” vào thế giới của Nvidia. AMD nổi lên ở mảng suy luận (inference), sân chơi mà Nvidia thống trị; Qualcomm nhảy vào chip trung tâm dữ liệu; hàng loạt startup chip AI như Groq bắt đầu có lực, nhất là ở Trung Đông. Ngay cả OpenAI, đồng minh thân thiết của Nvidia cũng lao vào tự làm silicon để bớt lệ thuộc. Dylan Patel (SemiAnalysis) viết vào giữa tháng 11 rằng chip của OpenAI có thể tốt đến mức Microsoft sẽ chọn nó thay vì Maia của chính mình.

Mạng lưới quan hệ vì thế càng rối, khi ai cũng “bắt tay đa hướng”. Khách hàng lớn nhất của CoreWeave là Microsoft; hãng này muốn mở rộng phục vụ OpenAI và startup AI khác. OpenAI vừa là khách, vừa là nhà đầu tư của CoreWeave, và sắp thành đối thủ khi liên danh Stargate đi vào hoạt động.

HỆ MẶT TRỜI NVIDIA

Trong vòng xoáy đó, hai mối quan hệ của Nvidia với OpenAI và CoreWeave khiến phe “nếu xui thì sao” là đáng lo ngại nhất. “Nvidia khéo dựng một hệ sinh thái của riêng mình để cạnh tranh năng lực trung tâm dữ liệu với các hyperscaler lớn”, nguồn hạ tầng AI nói.

Cách làm giống “vendor financing”: Doanh nghiệp cho khách vay để họ mua chính sản phẩm của mình, như hãng xe cho vay mua xe. Miễn là có nhu cầu thực, thì không sao.

Chiến lược của Nvidia hướng đến “cầu trực tiếp/được tuyển chọn”. Mặt trái: Tài trợ hào phóng có thể thổi phồng vay mượn và đẩy công suất tính toán AI vượt xa nhu cầu thực có thể theo kịp. Tuy nhiên, đây không phải trò “vòng vo” từng giết Nortel hay Lucent thời cáp quang, họ cho khách vay để… chất hàng tồn.

Nước cờ táo bạo nhất sẽ là: Thỏa thuận với OpenAI. Huang coi “cha đẻ” ChatGPT là mũi giáo của kỷ nguyên mới và hàm ý rằng: Khách hàng lớn nhất mai này. Ông dự đoán OpenAI sẽ thành “hyperscaler đa nghìn tỷ USD” tiếp theo. Trước đó, OpenAI mới chỉ mon men vai trò hyperscaler qua dự án Stargate; họ không tự vận hành data center, chủ yếu thuê của Big Four (đặc biệt Microsoft). Bắt tay Nvidia là để biến OpenAI thành đối trọng lớn, đồng thời vẫn là… khách hàng.

Theo thỏa thuận (công bố cuối tháng 9), Nvidia sẽ mua tối đa 100 tỷ USD cổ phần OpenAI, giúp hãng này trang bị hàng loạt data center với công suất tổng khoảng 10 GW, chi phí ước 500 tỷ USD. Việc này sẽ được tiến hành xây theo “tầng”: Mỗi tầng Nvidia cung cấp 10 tỷ USD tài trợ, OpenAI góp 40 tỷ USD, và khoảng 30 tỷ USD… mua chip Nvidia.

Nhưng Luria cảnh báo vô vàn rủi ro. OpenAI phải tự xoay thêm 40 tỷ USD mỗi “tầng”, một điều cực khó. Đến nay, OpenAI sống bằng vốn cổ phần, nhưng giờ bước vào kỷ nguyên đầu tư siêu lớn trong khi đang “đốt tiền”: Nửa đầu năm nay lỗ 13,5 tỷ USD trên doanh thu 4,3 tỷ USD. Báo cáo gần đây dự tính lỗ hoạt động 74 tỷ USD năm 2028 và hòa vốn năm 2030. Nghĩa là phần lớn 400 tỷ USD còn lại sẽ phải đi vay.

Tổng cam kết hạ tầng AI của OpenAI đã khoảng 1,4 nghìn tỷ USD, gồm 300 tỷ USD xây bởi Oracle (gắn với đặt hàng GPU Nvidia). Cơn cuồng tín có thể giúp họ vay được hàng trăm tỷ USD để gom GPU. Nhưng như chuyên gia Nick Del Deo của MoffettNathanson nói: “OpenAI là mô hình kinh doanh chưa được kiểm chứng”. Đáng chú ý: Nvidia mới chỉ là nhà đầu tư cổ phần, chưa dùng bảng cân đối để bảo lãnh núi nợ OpenAI cần vay. Và OpenAI cũng không muốn “trói” vào Nvidia: Họ đang nói chuyện với nhà cung cấp chip khác và tự thiết kế chip riêng.

Mối hợp tác thứ hai: CoreWeave. Đây là “neocloud” lớn nhất đang lắp đặt hạ tầng AI với tốc độ chóng mặt. Xuất thân từ đào coin, CoreWeave đang gánh núi nợ mà giới phân tích hoài nghi có thể “phóng to” để thoát ra. Nvidia vì thế ra tay giúp công ty mua chip với khối lượng lớn hơn nhiều so với khả năng tự thân. Nvidia rót 250 triệu USD để “chống lưng” cho thương vụ IPO chật vật của CoreWeave năm nay và nắm hơn 6% cổ phần.

CoreWeave đến nay chỉ dùng GPU Nvidia. Họ đã vận hành 33 trung tâm dữ liệu, đều xài GPU của “ông lớn”, và tự nhận có backlog 56 tỷ USD hợp đồng hạ tầng AI. Nvidia còn dùng ảnh hưởng để kéo các startup đầy hứa hẹn vốn khó vay vốn để thuê hạ tầng vào CoreWeave. Cuối tháng 9, Nvidia ký cam kết sẽ mua 6,3 tỷ USD công suất tính toán nếu CoreWeave không cho thuê/bán được. “Giống như ký bảo lãnh khoản vay”, Del Deo nói. Nguồn tin thân cận CoreWeave cho rằng nhờ vậy họ có thể cấp công suất cho Mistral, Cohere… những cái tên có thể thành “sao” AI mai này.

Với Nvidia, CoreWeave đóng vai “OpenAI thứ hai”: Kéo nhu cầu rời khỏi data center Microsoft/Amazon, vốn chạy GPU Nvidia sang cơ sở của CoreWeave. Trong báo cáo 80 trang (tháng 3), Del Deo khen năng lực kỹ thuật và dịch vụ khách hàng của CoreWeave. Vấn đề tiềm ẩn: Khi ký hợp đồng với một hyperscaler mạnh về tín nhiệm (ví dụ Microsoft) cần thuê thêm công suất, dòng tiền thuê là “tiền tươi”, CoreWeave dễ huy động vốn vì chắc chắn được trả.

Nhưng để xây “khối Nvidia mới”, CoreWeave lại nhận khách non trẻ đốt tiền, thiếu xếp hạng tín nhiệm. Trường hợp lớn nhất chính là hợp đồng với OpenAI, thêm một tầng đan cài trong “ma trận” Nvidia. Điều khoản yêu cầu CoreWeave cung cấp 22,4 tỷ USD công suất hạ tầng AI (chắc chắn chạy GPU Nvidia) trong khoảng 5 năm. Dựa trên kỳ vọng “siêu sao” OpenAI, CoreWeave đã vay ngân hàng một phần với lãi suất trên 8%. “Các hợp đồng với OpenAI và khách dưới chuẩn đầu tư làm rủi ro tăng”, Del Deo kết luận.

CoreWeave, giống OpenAI, âm dòng tiền và vay mạnh để mở rộng. CEO Michael Intrator ví công ty là “xe đua, không phải minivan”, “nợ là nhiên liệu”. Nhưng liệu đó cũng là mồi lửa?

NGÒI NỔ NỢ?

Với vấn đề này, việc hiểu ai đang nợ và nợ ai sẽ là chìa khóa. Vỏ nhà xưởng data center thường do các công ty BĐS (REIT) xây, dùng vốn vay xây dựng, rồi cho hyperscaler thuê. “Ông lớn” có thể tự bỏ tiền mua máy móc; còn CoreWeave hay OpenAI thiếu nguồn lực, buộc phải vay từ nhiều bên.

“Thiên hà” mới Nvidia lắp ghép đang đầy ắp những cái tên chưa chứng minh kiếm tiền bền vững, nhưng lại gánh khoản vay khổng lồ để dựng “đế chế” hạ tầng AI.

Dĩ nhiên, nếu nhu cầu từ khách doanh nghiệp của Microsoft thấp hơn kỳ vọng, họ vẫn trả tiền thuê nhà cho REIT và trả nợ thiết bị, ít rủi ro. Nhưng với “thiên hà” Nvidia, các bên như OpenAI phải đi vay để mua núi GPU. CoreWeave và OpenAI có ký hợp đồng cho thuê công suất với khách, nhưng để khách tiếp tục thuê, họ phải kiếm được lợi nhuận dày từ “cú nhảy vọt” công nghệ này. Nếu không, thị trường có thể tràn ngập data center vắng khách và GPU bị “siết nợ”, tuồn ngược trở lại. Khi đó, các “hyperscaler mới” được Nvidia chống lưng không trả nổi tiền thuê nhà xưởng, lẫn lãi gốc cho GPU, kéo đổ tín dụng xây data center và cầu GPU Nvidia.

Kịch bản đó không khiến người tin đạo AI chùn bước. “Nvidia đã vượt lên hết lần này tới lần khác”, một lãnh đạo tại khách hàng lớn của Nvidia nói. “Họ rút ngắn chu kỳ sản phẩm liên tục. Ai cũng phải đuổi theo”.

Nhưng người tỉnh táo phải nhíu mày trước lượng tiền đổ vào AI và mức lợi ích thực thu về đến nay. Tổng chi hạ tầng AI của Big Four sẽ vào khoảng 330 tỷ USD trong năm 2025 (theo tự công bố), và còn tăng mạnh năm tới. Citi dự báo chi cho tất cả hyperscaler năm sau đạt 490 tỷ USD. Giả sử “khiêm tốn” rằng Big Four chi 700 tỷ USD trong hai năm: Để đạt lợi suất 15% trên số vốn đó, họ phải “đẻ” thêm 105 tỷ USD lợi nhuận AI mỗi năm, tương đương gần 1/3 tổng 350 tỷ USD lợi nhuận GAAP bốn quý qua của cả bốn.

Một lãnh đạo từng huy động vốn lớn cho hạ tầng AI nói: “Tôi cũng lo lượng vốn khổng lồ đổ vào mà chưa thấy đường lợi nhuận rõ ràng. Ta cảm nhận được tiết kiệm năng suất và đột phá nghiên cứu. Nhưng ‘killer app’ tạo giá trị đại trà là gì? Tất cả những câu hỏi này đều chưa thể trả lời”. Và ông đặt câu hỏi có lẽ Huang cũng trăn trở khi ngừng “bán hàng” để đưa ra kết luận: “Nếu lợi tức kém xa kỳ vọng, ai sẽ chịu đau?”

Chừng nào câu chuyện “AI vĩ đại” còn tiếp diễn, cỗ máy in tiền của Nvidia vẫn chạy. Nhưng nếu câu chuyện đổi chiều, nỗi đau sẽ tìm đến Nvidia và nhà đầu tư của họ.

Theo: Fortune